Dans le cadre du GT num #IA_EO, l’un des 3 axes de travail concerne l’exploitation intelligible des Learning Analytics par l’utilisateur (apprenant, enseignant, institutions, parents, etc.) et leur combinaison avec les techniques de l’IA.

Suite à notre deuxième webinaire dont nous vous parlions ici et toujours dans la continuité des échanges autour de l’éducation, de l’IA et notamment des sujets d’explicabilité et d’interprétabilité, nous avons organisé un troisième webinaire le 15 avril dernier, consacré à une étude sur les explications du résultat d’un classifieur.

Un webinaire le 15 avril animé par Laurence Rozé

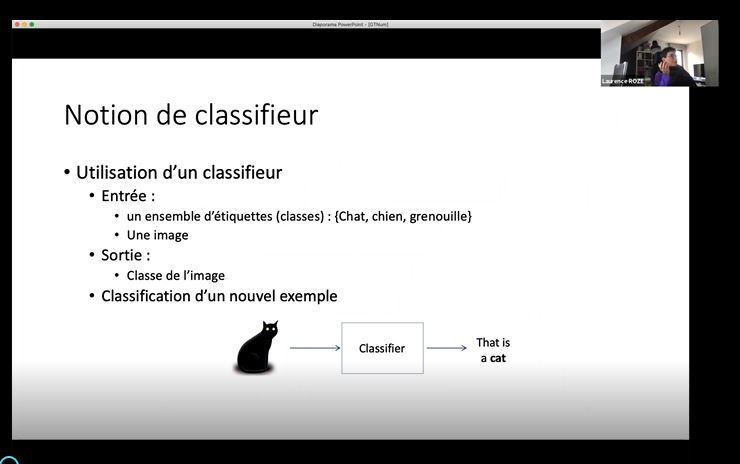

Lors de cette présentation, Laurence Rozé nous a tout d’abord, introduit la notion de classifieur avant de nous proposer un état de l’art des différentes approches proposées pour générer des explications : méthodes globales, méthodes locales et méthodes par inspections. La présentation a été plus particulièrement dédiée aux méthodes locales développées par son équipe et à leurs limites. Enfin, la portabilité de ces méthodes vers la problématique de STAPS et du projet ApLLy a été analysée et discutée.

Vous pouvez désormais retrouver la présentation en rediffusion ici.

Quelles perspectives ?

Suite à cette présentation, les participants du GTnum IA_EO ont souhaité organiser une réunion avec les responsables du projet ApLLy, le Ministère de l’Education Nationale, de la Jeunesse et des Sports et les DANEs associées au projet afin de co-construire des pistes de travail permettant de favoriser l’émergence de projets communs et de partage de données réelles afin de continuer nos travaux sur l’étude des relations entre décrochage (remédiation, prédiction), interprétabilité, explicabilité et confiance.

Nous vous tiendrons informé de l’évolution de ces travaux.

Sauf indication contraire, l’ensemble des contenus de ce site https://chaireunescorelia.univ-nantes.fr/ est mis à disposition selon les termes de la Licence Creative Commons Attribution 4.0 International.